Flume学习-采集端口数据存入kafka

迪丽瓦拉

2025-05-28 15:51:57

0次

启动zookeeper、kafka并创建kafka主题

./bin/zkServer.sh start./bin/kafka-server-start.sh -daemon ./config/server.properties./bin/kafka-topic.sh --create --topic hunter --partitions 3 --replication-factor 1 --zookeeper localhost:90922、创建flume-kafka.conf配置文件

用于采集socket数据后存入kafka

在flume文件夹中的conf下新建flume-kafka.conf配置文件

vim flume-kafka.confa1.sources = s1

a1.channels = c1

a1.sinks = k1a1.sources.s1.type = netcat

a1.sources.s1.bind = localhost

a1.sources.s1.port = 10050 a1.sinks.k1.type = org.apache.flume.sink.kafka.KafkaSink

a1.sinks.k1.kafka.topic = hunter

a1.sinks.k1.kafka.bootstrap.servers = master:9092a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100a1.sources.s1.channels = c1

a1.sinks.k1.channel = c1设置监听本地端口10050 netcat发送的socket数据,讲采集到的数据存入kafka的hunter主题中

3、启动flume

./bin/flue-ng agent -n a1 -c conf -f ./conf/flume-kafka.conf -Dflume.root.logger=INFO,console./bin/flume-ng:启动Flume-ng二进制文件。

agent:指定要启动的Flume组件类型为代理。

-c conf:设置Flume配置文件所在的目录为当前目录下的conf目录。

-f ./conf/flume_kafka.conf:指定Flume代理使用的配置文件路径和名称。

-n a1:给Flume代理指定一个名称为a1。

-Dflume.root.logger=INFO,console:设置Flume代理的日志级别为INFO,并将日志输出到控制台。

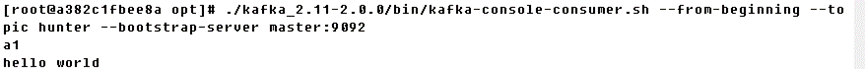

4、创建kafka消费者

./bin/kafka-console-consumer.sh --from-beginning --topic hunter --bootstrap-server localhost:9092/bin/kafka-console-consumer.sh:启动 Kafka 控制台消费者。

--from-beginning:从该主题的开始位置读取消息。

--topic hunter:指定要消费的主题名称为 "hunter"。

--bootstrap-server 集群各个主机:端口:指定连接到 Kafka 集群的所有 broker 的主机名和端口号

5、netcat向本地10050端口发送socket数据

先开启flume,这里就会直接进入输入模式

nc localhost 10050读取成功示例

上一篇:企业电子招投标系统之首页设计

下一篇:【JavaSE】知识点总结(4)

相关内容

热门资讯

linux入门---制作进度条

了解缓冲区 我们首先来看看下面的操作: 我们首先创建了一个文件并在这个文件里面添加了...

C++ 机房预约系统(六):学...

8、 学生模块 8.1 学生子菜单、登录和注销 实现步骤: 在Student.cpp的...

A.机器学习入门算法(三):基...

机器学习算法(三):K近邻(k-nearest neigh...

数字温湿度传感器DHT11模块...

模块实例https://blog.csdn.net/qq_38393591/article/deta...

有限元三角形单元的等效节点力

文章目录前言一、重新复习一下有限元三角形单元的理论1、三角形单元的形函数(Nÿ...

Redis 所有支持的数据结构...

Redis 是一种开源的基于键值对存储的 NoSQL 数据库,支持多种数据结构。以下是...

win下pytorch安装—c...

安装目录一、cuda安装1.1、cuda版本选择1.2、下载安装二、cudnn安装三、pytorch...

MySQL基础-多表查询

文章目录MySQL基础-多表查询一、案例及引入1、基础概念2、笛卡尔积的理解二、多表查询的分类1、等...

keil调试专题篇

调试的前提是需要连接调试器比如STLINK。 然后点击菜单或者快捷图标均可进入调试模式。 如果前面...

MATLAB | 全网最详细网...

一篇超超超长,超超超全面网络图绘制教程,本篇基本能讲清楚所有绘制要点&#...

IHome主页 - 让你的浏览...

随着互联网的发展,人们越来越离不开浏览器了。每天上班、学习、娱乐,浏览器...

TCP 协议

一、TCP 协议概念 TCP即传输控制协议(Transmission Control ...

营业执照的经营范围有哪些

营业执照的经营范围有哪些 经营范围是指企业可以从事的生产经营与服务项目,是进行公司注册...

C++ 可变体(variant...

一、可变体(variant) 基础用法 Union的问题: 无法知道当前使用的类型是什...

血压计语音芯片,电子医疗设备声...

语音电子血压计是带有语音提示功能的电子血压计,测量前至测量结果全程语音播报...

MySQL OCP888题解0...

文章目录1、原题1.1、英文原题1.2、答案2、题目解析2.1、题干解析2.2、选项解析3、知识点3...

【2023-Pytorch-检...

(肆十二想说的一些话)Yolo这个系列我们已经更新了大概一年的时间,现在基本的流程也走走通了,包含数...

实战项目:保险行业用户分类

这里写目录标题1、项目介绍1.1 行业背景1.2 数据介绍2、代码实现导入数据探索数据处理列标签名异...

记录--我在前端干工地(thr...

这里给大家分享我在网上总结出来的一些知识,希望对大家有所帮助 前段时间接触了Th...

43 openEuler搭建A...

文章目录43 openEuler搭建Apache服务器-配置文件说明和管理模块43.1 配置文件说明...