OpenAI GPT-4 申请使用

这里写自定义目录标题

- GPT-4 简介

- 如何使用

- 如何申请 GPT-4 API

GPT-4 简介

GPT-4可以接受图像和文本输入,而GPT-3.5只接受文本;GPT-4在各种专业和学术基准上的表现达到“人类水平”,在事实性、可引导性和可控制方面取得了“史上最佳结果”;当任务的复杂性达到足够的阈值时,GPT-4比GPT-3.5更可靠,更有创造力,能够处理更细微的指令。

3月14日,ChatGPT的开发机构OpenAI正式发布其里程碑之作GPT-4。

GPT-4是一个多模态大模型(接受图像和文本输入,生成文本)。相比上一代的GPT-3,GPT-4可以更准确地解决难题,具有更广泛的常识和解决问题的能力:更具创造性和协作性;能够处理超过25000个单词的文本,允许长文内容创建、扩展对话以及文档搜索和分析等用例。

此外,GPT-4的高级推理能力超越了ChatGPT。在SAT等绝大多数专业测试以及相关学术基准评测中,GPT-4的分数高于ChatGPT。

OpenAI花了6个月时间使GPT-4更安全、更具一致性。在内部评估中,与GPT-3.5相比,GPT-4对不允许内容做出回应的可能性降低82%,给出事实性回应的可能性高40% 。GPT-4引入了更多人类反馈数据进行训练,不断吸取现实世界使用的经验教训进行改进。

GPT-4可以接受文本和图像的提示语。比如,可以让用户指定任何视觉或语言任务,它可以生成文本输出(自然语言、代码等),给定的输入包括带有文字和照片的文件、图表或屏幕截图,GPT-4表现出与纯文本输入类似的能力。不过,目前图像输入仍然属于研究预览,不针对普通用户开放。

此外,GPT-4在人类反馈的强化学习(RLHF)训练中加入了一个额外的安全奖励信号,通过训练模型来拒绝对此类内容的请求,从而减少有害产出。

与GPT-3.5相比,这些缓解措施大大改善了GPT-4的许多安全性能。与GPT-3.5相比,OpenAI将模型对非法内容请求的响应倾向降低了82%,而GPT-4对敏感请求(如医疗建议和自我伤害)的响应符合OpenAI政策的频率提高了29%。

如何使用

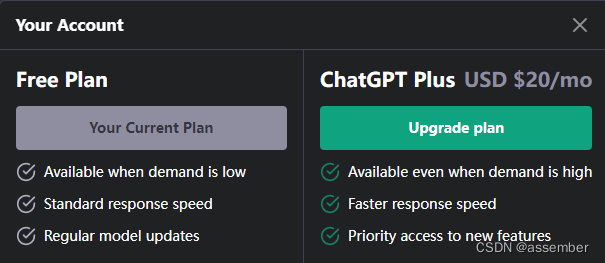

ChatGPT Plus 用户将获得有使用上限的GPT-4权限,OpenAI将根据实际需求和系统性能调整确切的使用上限,但预计容量将受到严重限制。暂时还不支持图片和文件输入,该功能还在测试版本中

如何申请 GPT-4 API

前提:你需要申请 OpenAI 账户,我开通 API 功能

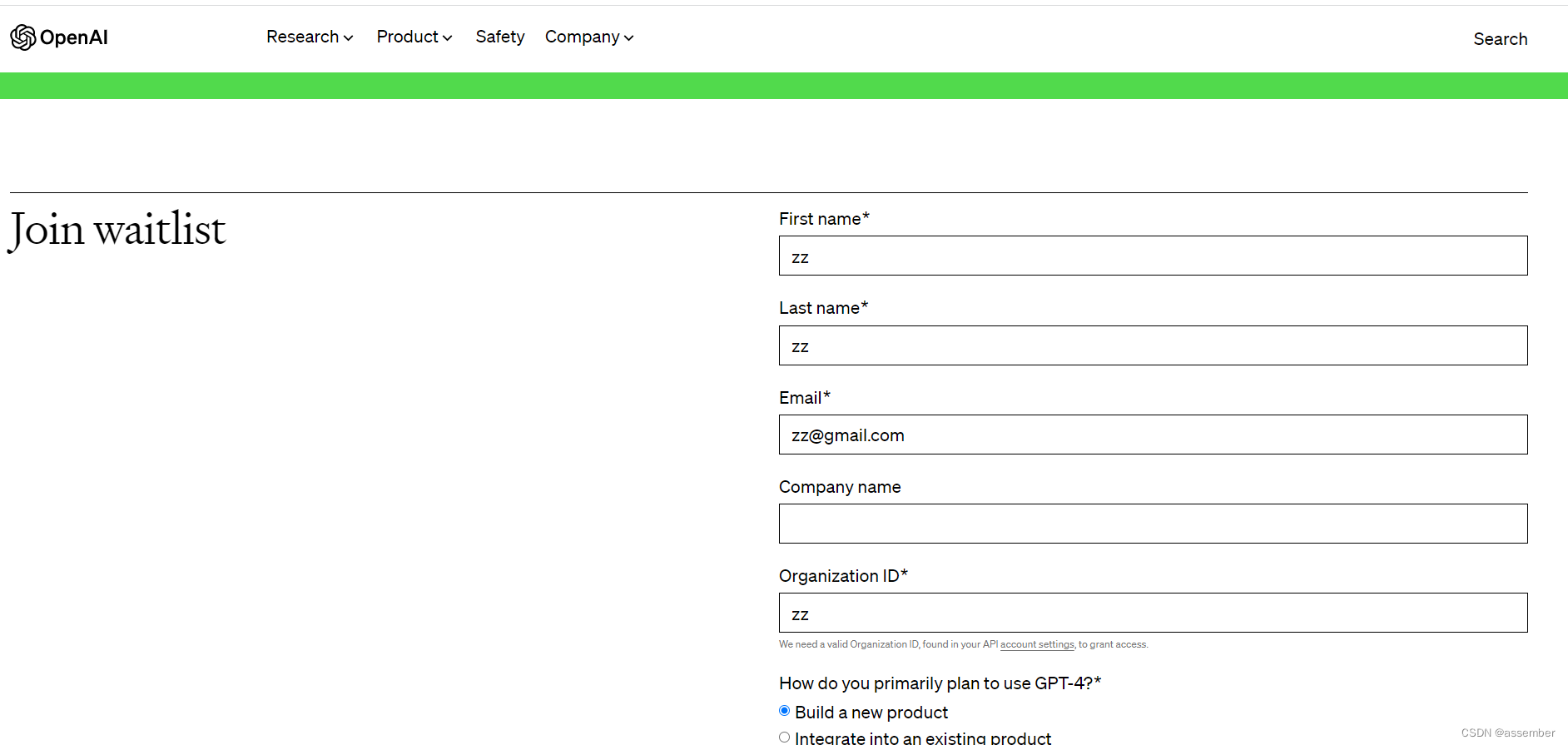

进入 API 权限申请页面: GPT-4 Waitlist

登陆后,填写信息将 GPT-4 加入waitlist

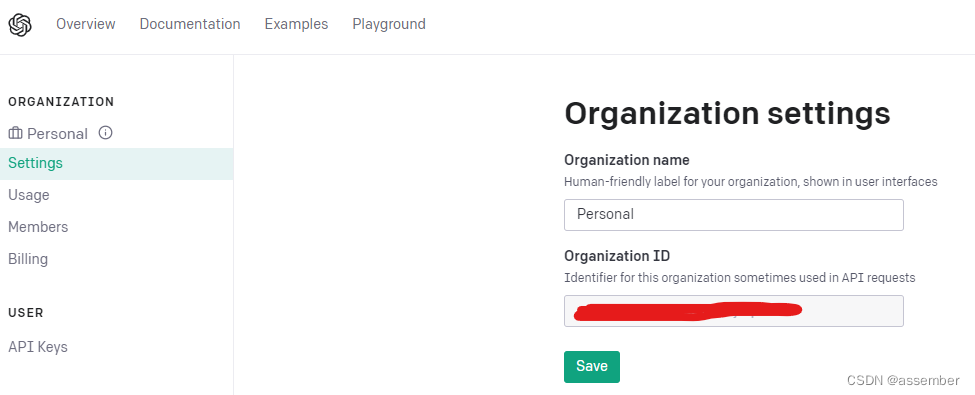

其中,Organization ID 是自己账号中自动生成的,点击下方灰色小字中的链接可以直接跳转

或者点击这里获取: org-settings

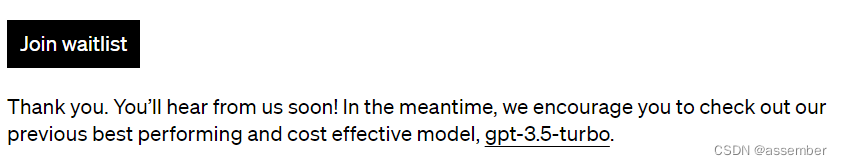

申请成功后,下方会提示请等待回复,可以先尝试使用 gpt-3.5-turbo 模型

获得访问权限后,用户目前可以向GPT-4模型发出纯文本请求(图像输入仍处于有限的测试阶段)。定价为每1k个prompt token 0.03美元,每1k个completion token 0.06美元。